Neuer Podcast ?Explaining Explainability“ befasst sich mit erkl?rbarer KI

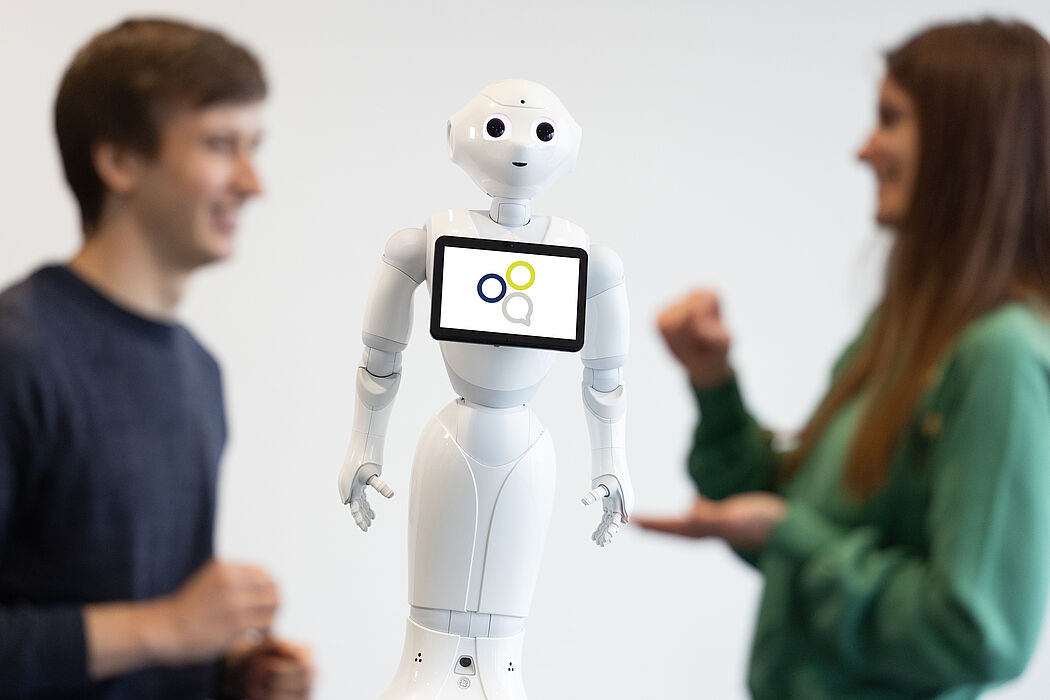

Künstliche Intelligenz (KI) begegnet den Menschen mittlerweile in fast allen Lebensbereichen. KI soll unterstützen, beraten und bei schwierigen Entscheidungsfindungen objektive und optimierte L?sungsvorschl?ge liefern. Wie aber k?nnen Menschen nachvollziehen, warum und wie eine KI zu ihrem jeweiligen Ergebnis gekommen ist? Im Sonderforschungsbereich/ Transregio (SFB/TRR) 318 der Universit?ten Bielefeld und Paderborn besch?ftigt sich ein interdisziplin?res Forschungsteam mit dieser Problematik: Ziel sind verstehbare Assistenzsysteme, die beispielsweise Rückfragen der Nutzer*innen beantworten und passgenaue Erkl?rungen liefern k?nnen. Im neuen Forschungspodcast geben die Forschenden Einblick in ihre Arbeit und erkl?ren, warum erkl?rbare KI einen wichtigen Schritt in die Zukunft der KI-Forschung darstellt.

Wissenschaftler*innen aus sechs Disziplinen – Informatik, Linguistik, Medienwissenschaft, Psychologie, Soziologie und Wirtschaftswissenschaften – forschen im SFB an dem Prozess des interaktiven Erkl?rens und wie dieser auf KI-Systeme übertragen werden kann. Der Podcast ?Explaining Explainability“ (zu deutsch: Erkl?rbarkeit erkl?ren) bringt alle Disziplinen zusammen: Darin spricht Moderatorin Prof. Dr. Britta Wrede mit jeweils zwei Forschenden aus unterschiedlichen Fachrichtungen über deren aktuelle Forschung, Herausforderungen, Anwendungsbereiche und die Relevanz der Erkl?rbaren KI.

Die erste Episode, deren redaktionelles Konzept im Rahmen einer Masterarbeit im Studiengang Interdisziplin?re Medienwissenschaft in Bielefeld entstanden ist, n?hert sich dem Thema Erkl?rbarkeit aus Perspektiven der Informatik und der Linguistik. Zu Gast sind die Sprecher*innen des SFB, Prof. Dr. Philipp Cimiano (Informatik) von der Universit?t Bielefeld und Prof. Dr. Katharina Rohlfing (Psycholinguistik) von der Universit?t Paderborn. Was hei?t eigentlich Explainability, warum und in welchen Bereichen ist sie so wichtig? Wo steht die Forschung aktuell – und was sind die gr??ten Herausforderungen?

Wie k?nnen hochtechnische Abl?ufe für jeden verst?ndlich dargestellt werden?

?Was die KI-Forschung im TRR so besonders macht, ist der Fokus auf die Person, der etwas erkl?rt wird“, sagt Philipp Cimiano. ?Wie lassen sich hochtechnische Abl?ufe und Funktionen allgemein verst?ndlich wiedergeben? Gegens?tze, Vergleiche und Abstufungen k?nnen hier Licht ins Dunkel bringen. Wenn wir etwa den Entscheidungsprozess durch ein Maschinen-gelerntes Modell erkl?ren wollen, dann spielen die Eigenschaften des Falles, in dem eine Entscheidung getroffen wird, sogenannte Features, eine wichtige Rolle. Die Entscheidung kann dadurch erkl?rt werden, dass die Wichtigkeit der einzelnen Features bei der Entscheidung nachvollziehbar gemacht wird.“ Im Podcast erkl?ren die Wissenschaftler*innen anhand konkreter Beispiele, worum es bei ihrer Forschung geht und geben Einblicke in ihren Forschungsalltag.

Die weiteren Episoden, ebenfalls Teil des Masterprojekts, folgen im zweimonatigen Rhythmus. In der n?chsten Podcast-Folge wird es um den Prozess der Alltagserkl?rungen gehen: Was hat die Linguistik bislang zu den Strukturen von Alltagserkl?rungen herausgefunden – und wie kann die Informatik diese Erkenntnisse für das Design von KI-Systemen weiterverarbeiten?